一、背景与开源意义

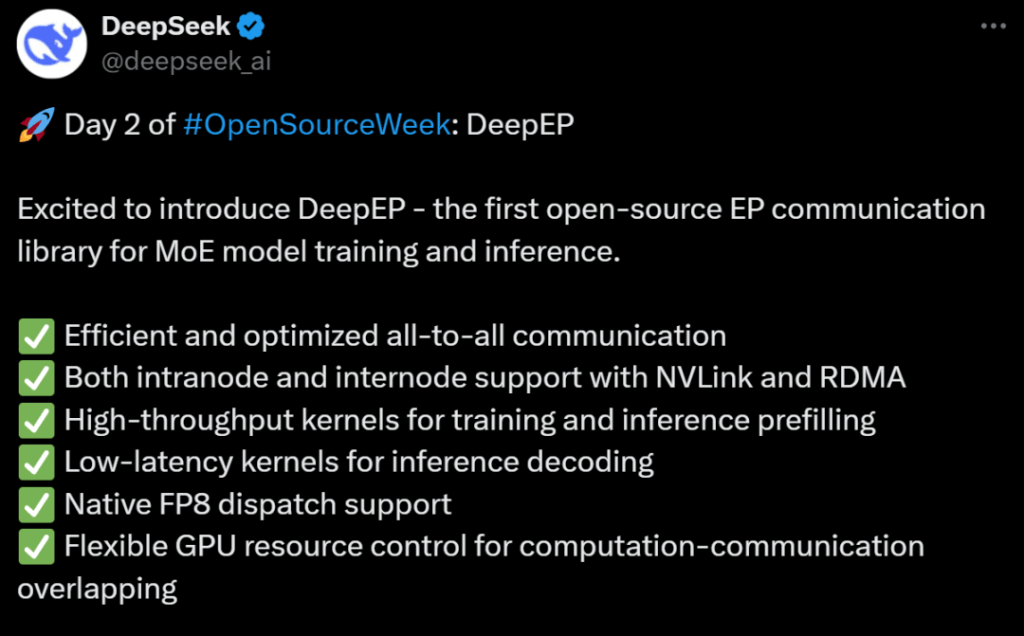

2025年2月25日,DeepSeek在其“开源周”活动第二天发布了DeepEP,这是全球首个专为混合专家(Mixture of Experts, MoE)模型设计的开源EP(Expert Parallelism)通信库。此次开源填补了MoE模型在分布式训练与推理场景中缺乏专用通信工具的空白,标志着高性能AI底层技术的重要突破。

MoE模型作为一种高效的大模型架构,通过动态分配专家网络处理不同任务,显著提升了模型容量与计算效率。然而,其复杂的通信需求(如专家间的数据分发与合并)对底层通信库提出了高吞吐、低延迟、资源利用率等多重挑战。DeepEP的诞生正是为了解决这些问题,通过软硬件协同优化,为MoE模型提供了“通信管家”级别的支持。

二、核心技术特性

二、核心技术特性

1. 高效通信架构

DeepEP的核心优势在于其全对全(All-to-All)通信优化。通过结合NVLink(节点内高速互联)和RDMA(远程直接内存访问)技术,DeepEP实现了节点内与节点间的高效数据传输。这种设计特别针对MoE模型中频繁的专家数据交换场景,例如在训练时的参数同步和推理时的动态路由分配。

- 异构网络优化:针对NVLink与RDMA之间的非对称带宽转发场景,DeepEP设计了专用内核,确保数据在不同域间的高效传输。

- 动态SM控制:支持流式多处理器(Streaming Multiprocessors, SM)数量的动态调整,平衡训练与推理任务的吞吐量需求。

2. 高性能计算内核

DeepEP提供两类核心计算内核,分别针对不同场景优化:

- 高吞吐量内核:适用于训练和推理预填充阶段,通过批量处理数据提升整体吞吐效率。

- 低延迟内核:专为推理解码任务设计,采用纯RDMA通信与自适应路由技术,将延迟降至最低。

3. 原生FP8支持与低精度调度

DeepEP全面支持FP8(8位浮点数)数据格式,显著降低了计算资源消耗。这一特性尤其适合大规模分布式训练,能够在保证模型精度的前提下,减少显存占用和通信带宽压力。

4. 资源控制与计算-通信重叠

通过灵活的GPU资源管理策略,DeepEP实现了计算与通信过程的重叠执行。例如,采用基于Hook的异步调度机制,在不占用SM资源的情况下完成通信任务,最大化GPU利用率。

三、应用场景与性能优势

1. MoE模型训练加速

在训练阶段,DeepEP通过高吞吐量内核优化专家网络间的参数同步。其支持大规模分布式训练集群,例如在多GPU节点环境下,数据分发与合并效率提升显著,缩短了模型收敛时间。

2. 实时推理优化

针对推理解码任务,DeepEP的低延迟内核采用纯RDMA通信,结合自适应路由技术,确保毫秒级响应速度。这一特性在对话系统、实时推荐等场景中表现尤为突出。

3. 兼容性与扩展性

- 硬件兼容:当前版本主要支持Hopper架构GPU(如NVIDIA H100),未来计划扩展至更多架构。

- 框架适配:与PyTorch 2.1+深度集成,支持CUDA 12.3及以上版本,开发者可无缝接入现有训练流程。

四、社区影响与开源生态

DeepEP在开源后20分钟内即获得超过1000个GitHub Star,迅速成为AI开发者社区的热点项目。其开源地址(GitHub链接)提供了完整的文档与示例代码,降低了使用门槛。

开源意义:

- 填补技术空白:此前MoE领域缺乏专用通信库,开发者需依赖通用框架(如NCCL),效率受限。DeepEP的发布直接解决了这一痛点。

- 推动行业标准:通过公开核心代码,DeepEP有望成为MoE模型通信的事实标准,加速AI大模型的迭代与落地。

五、未来展望与挑战

1. 技术迭代方向

- 多架构支持:扩展至AMD GPU及其他异构计算设备。

- 自动化调优:引入动态参数配置工具,简化超参数优化流程。

2. 生态建设

DeepSeek计划通过社区协作完善生态,例如开发与TensorFlow、JAX等框架的适配接口,并推出企业级支持服务。

3. 挑战与应对

当前DeepEP对硬件要求较高(如Hopper GPU),未来需通过算法优化降低部署成本。此外,大规模集群中的故障容错机制仍需进一步增强。

六、结语

DeepEP的发布不仅是DeepSeek技术实力的体现,更是开源社区推动AI基础设施进步的典范。通过高效通信、低延迟推理与灵活资源管理,DeepEP为MoE模型的普及提供了坚实的技术底座。随着生态的完善,其有望成为下一代大模型训练与推理的核心组件,助力AI技术迈向新的高度。

扩展阅读

- DeepEP GitHub仓库:https://github.com/deepseek-ai/DeepEP